LC:AI集群和HPC是CPO的正确切入点

ICC讯(编译:Nina)对于光通信行业来说,从可插拔光学器件到共封装光学器件(Co-packaged Optics,CPO)的转变是令人兴奋的,但对于数据中心采用CPO,很重要的一点是,大家要抱切合实际的期望。除了众多制造挑战和满足降低功耗的目标之外,最终用户还必须接受CPO作为一种持续降低成本的可行方法。

人工智能(AI)集群和高性能计算机(HPC)采用CPO的时间有更多的不确定性,但这个市场更愿意冒险和使用创新解决方案,即使它们是专有的(Proprietary)。这些系统甚至比数据中心的计算集群更需要带宽。专家认为,GPU互连现在可使用当前所使用的互连带宽的10倍。未来,分散集群(Disaggregated clusters)的出现还需要再增加10倍。

AI集群和HPC的架构正在不断发展。我们可能会看到CPO部署在GPU、TPU上以及以太网、InfiniBand或NVLink交换机上。有多种基于FPGA的加速器(Accelerator)也可能受益于CPO。LC当前的预测将所有这些用例组合成一个“AI集群和HPC”应用类别。

大型数据中心的计算集群将是CPO的第二大应用。一些大客户不打算使用专有的CPO设计,而是更愿意等待基于标准CPO解决方案的新的竞争生态系统出现。这将限制早期部署的规模,但会有客户愿意冒险。

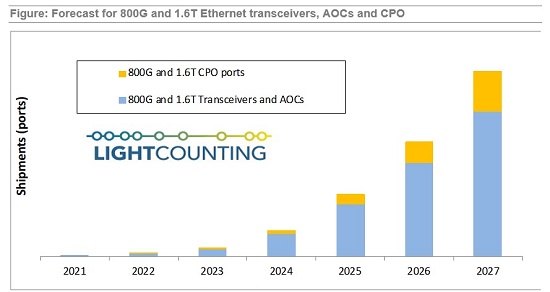

下图显示了LC对CPO端口和可插拔以太网光收发器以及AOC出货量的预测。可插拔器件将在未来5年内甚至更长的时间里继续主导市场。然而,CPO端口将占到2027年部署的800G和1.6T端口总数的近30%。

CPO支持者可能会认为这种观点过于保守,但LC怀疑它可能过于乐观。预测者往往会低估改变行业方向所需的时间。

在此分析中,LC根据800G和1.6T收发器等效物(或端口)来计算CPO,但CPO引擎可以将多个800G或1.6T端口组合成一个光芯片(Opto-chiplet)。例如,单个3.2Tbps引擎相当于4个800G CPO端口。每个AOC按两个端口计算。

LC目前的预测不包括由OIF开发的近封装光学器件(Near Package Optics,NPO)的出货量。Meta确实计划在51.2T交换机上使用NPO,但这些可能只是数量有限的概念证明试验。

所有CPO解决方案都将基于硅光子(SiP)技术吗?很可能不是。IBM正在开发基于VCSEL的系统。一家初创公司Avicena正在开发GaN micro LED,以实现极低功率、短距离(<10m) 连接。还有更多的初创公司仍处于隐形模式,LC表示期待看到更多技术进入竞争。 但至少目前,硅光是领先者和终极集成平台。